RBF#

- class sklearn.gaussian_process.kernels.RBF(length_scale=1.0, length_scale_bounds=(1e-05, 100000.0))[Quelle]#

Radialbasis-Funktionskernel (auch bekannt als quadratisch-exponentieller Kernel).

Der RBF-Kernel ist ein stationärer Kernel. Er ist auch als "squared exponential"-Kernel bekannt. Er wird durch einen Längenskala-Parameter \(l>0\) parametrisiert, der entweder ein Skalar (isotherme Variante des Kernels) oder ein Vektor mit der gleichen Anzahl von Dimensionen wie die Eingaben X (anisotrope Variante des Kernels) sein kann. Der Kernel ist gegeben durch

\[k(x_i, x_j) = \exp\left(- \frac{d(x_i, x_j)^2}{2l^2} \right)\]wobei \(l\) die Längenskala des Kernels und \(d(\cdot,\cdot)\) der euklidische Abstand ist. Ratschläge zur Einstellung des Längenskala-Parameters finden Sie z. B. in [1].

Dieser Kernel ist unendlich oft differenzierbar, was impliziert, dass Gauß-Prozesse mit diesem Kernel als Kovarianzfunktion mittlere quadratische Ableitungen aller Ordnungen aufweisen und somit sehr glatt sind. Weitere Details zum RBF-Kernel finden Sie in [2], Kapitel 4, Abschnitt 4.2.

Lesen Sie mehr im Benutzerhandbuch.

Hinzugefügt in Version 0.18.

- Parameter:

- length_scalefloat oder ndarray der Form (n_features,), Standardwert=1.0

Die Längenskala des Kernels. Wenn ein Float, wird ein isotroper Kernel verwendet. Wenn ein Array, wird ein anisotroper Kernel verwendet, bei dem jede Dimension von l die Längenskala der jeweiligen Merkmalsdimension definiert.

- length_scale_boundsPaar von Floats >= 0 oder „fixed“, Standardwert=(1e-5, 1e5)

Die untere und obere Grenze für ‘length_scale’. Wenn auf „fixed“ gesetzt, kann ‘length_scale’ während des Hyperparameter-Tunings nicht geändert werden.

Referenzen

Beispiele

>>> from sklearn.datasets import load_iris >>> from sklearn.gaussian_process import GaussianProcessClassifier >>> from sklearn.gaussian_process.kernels import RBF >>> X, y = load_iris(return_X_y=True) >>> kernel = 1.0 * RBF(1.0) >>> gpc = GaussianProcessClassifier(kernel=kernel, ... random_state=0).fit(X, y) >>> gpc.score(X, y) 0.9866 >>> gpc.predict_proba(X[:2,:]) array([[0.8354, 0.03228, 0.1322], [0.7906, 0.0652, 0.1441]])

- __call__(X, Y=None, eval_gradient=False)[Quelle]#

Gibt den Kernel k(X, Y) und optional seinen Gradienten zurück.

- Parameter:

- Xndarray mit Form (n_samples_X, n_features)

Linkes Argument des zurückgegebenen Kernels k(X, Y)

- Yndarray mit Form (n_samples_Y, n_features), Standardwert=None

Rechtes Argument des zurückgegebenen Kernels k(X, Y). Wenn None, wird stattdessen k(X, X) ausgewertet.

- eval_gradientbool, Standardwert=False

Bestimmt, ob der Gradient bezüglich des Logarithmus des Kernel-Hyperparameters berechnet wird. Nur unterstützt, wenn Y None ist.

- Gibt zurück:

- Kndarray mit Form (n_samples_X, n_samples_Y)

Kernel k(X, Y)

- K_gradientndarray mit Form (n_samples_X, n_samples_X, n_dims), optional

Der Gradient des Kernels k(X, X) bezüglich des Logarithmus des Hyperparameters des Kernels. Nur zurückgegeben, wenn

eval_gradientTrue ist.

- property bounds#

Gibt die log-transformierten Grenzen für theta zurück.

- Gibt zurück:

- boundsndarray mit Form (n_dims, 2)

Die log-transformierten Grenzen für die Hyperparameter theta des Kernels

- clone_with_theta(theta)[Quelle]#

Gibt eine Kopie von self mit den angegebenen Hyperparametern theta zurück.

- Parameter:

- thetandarray mit Form (n_dims,)

Die Hyperparameter

- diag(X)[Quelle]#

Gibt die Diagonale des Kernels k(X, X) zurück.

Das Ergebnis dieser Methode ist identisch mit np.diag(self(X)); sie kann jedoch effizienter ausgewertet werden, da nur die Diagonale ausgewertet wird.

- Parameter:

- Xndarray mit Form (n_samples_X, n_features)

Linkes Argument des zurückgegebenen Kernels k(X, Y)

- Gibt zurück:

- K_diagndarray mit Form (n_samples_X,)

Diagonale des Kerns k(X, X)

- get_params(deep=True)[Quelle]#

Parameter dieses Kernels abrufen.

- Parameter:

- deepbool, default=True

Wenn True, werden die Parameter für diesen Schätzer und die enthaltenen Unterobjekte, die Schätzer sind, zurückgegeben.

- Gibt zurück:

- paramsdict

Parameternamen, zugeordnet ihren Werten.

- property hyperparameters#

Gibt eine Liste aller Spezifikationen von Hyperparametern zurück.

- property n_dims#

Gibt die Anzahl der nicht-festen Hyperparameter des Kernels zurück.

- property requires_vector_input#

Gibt zurück, ob der Kernel auf Vektoren mit fester Länge oder generischen Objekten definiert ist. Standardmäßig True aus Kompatibilitätsgründen.

- set_params(**params)[Quelle]#

Parameter dieses Kernels setzen.

Die Methode funktioniert sowohl bei einfachen Kernels als auch bei verschachtelten Kernels. Letztere haben Parameter der Form

<component>__<parameter>, sodass es möglich ist, jede Komponente eines verschachtelten Objekts zu aktualisieren.- Gibt zurück:

- self

- property theta#

Gibt die (abgeflachten, log-transformierten) nicht-festen Hyperparameter zurück.

Beachten Sie, dass theta typischerweise die log-transformierten Werte der Hyperparameter des Kernels sind, da diese Darstellung des Suchraums besser für die Hyperparameter-Suche geeignet ist, da Hyperparameter wie Längen-Skalen natürlich auf einer logarithmischen Skala liegen.

- Gibt zurück:

- thetandarray mit Form (n_dims,)

Die nicht-festen, log-transformierten Hyperparameter des Kernels

Galeriebeispiele#

Vergleich von Kernel Ridge und Gauß-Prozess-Regression

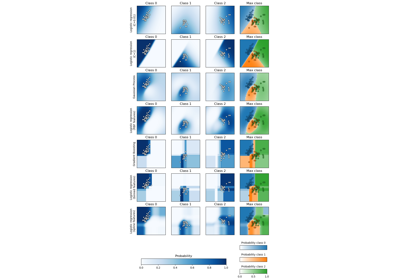

Probabilistische Vorhersagen mit Gauß-Prozess-Klassifikation (GPC)

Gauß-Prozess-Klassifikation (GPC) auf dem Iris-Datensatz

Illustration der Gauß-Prozess-Klassifikation (GPC) auf dem XOR-Datensatz

Prognose des CO2-Spiegels im Mona Loa Datensatz mittels Gauß-Prozess-Regression (GPR)

Fähigkeit der Gauß-Prozess-Regression (GPR) zur Schätzung des Datenrauschpegels

Gauß-Prozesse Regression: grundlegendes Einführungsexempel

Illustration von Prior und Posterior Gauß-Prozess für verschiedene Kerne