RandomForestClassifier#

- class sklearn.ensemble.RandomForestClassifier(n_estimators=100, *, criterion='gini', max_depth=None, min_samples_split=2, min_samples_leaf=1, min_weight_fraction_leaf=0.0, max_features='sqrt', max_leaf_nodes=None, min_impurity_decrease=0.0, bootstrap=True, oob_score=False, n_jobs=None, random_state=None, verbose=0, warm_start=False, class_weight=None, ccp_alpha=0.0, max_samples=None, monotonic_cst=None)[Quelle]#

Ein Random-Forest-Klassifikator.

Ein Random Forest ist ein Meta-Schätzer, der eine Anzahl von Entscheidungsbaum-Klassifikatoren auf verschiedenen Teilmengen des Datensatzes anpasst und den Durchschnitt zur Verbesserung der Vorhersagegenauigkeit und zur Kontrolle von Überanpassung verwendet. Bäume im Forest verwenden die Strategie der besten Teilung, d.h. äquivalent zur Übergabe von

splitter="best"an den zugrunde liegendenDecisionTreeClassifier. Die Größe der Teilmengen wird über den Parametermax_samplesgesteuert, wennbootstrap=True(Standard), andernfalls wird der gesamte Datensatz zum Aufbau jedes Baumes verwendet.Ein Vergleich zwischen baumbasierten Ensemble-Modellen finden Sie im Beispiel Vergleich von Random Forests und Histogram Gradient Boosting Modellen.

Dieser Estimator unterstützt nativ fehlende Werte (NaNs). Während des Trainings lernt der Baumgenerator an jedem Splitpunkt, ob Samples mit fehlenden Werten basierend auf dem potenziellen Gewinn zum linken oder rechten Kind gehen sollen. Bei der Vorhersage werden Samples mit fehlenden Werten folgerichtig dem linken oder rechten Kind zugeordnet. Wenn während des Trainings keine fehlenden Werte für ein bestimmtes Merkmal angetroffen wurden, werden Samples mit fehlenden Werten dem Kind mit den meisten Samples zugeordnet.

Lesen Sie mehr im Benutzerhandbuch.

- Parameter:

- n_estimatorsint, Standard=100

Die Anzahl der Bäume im Forest.

Geändert in Version 0.22: Der Standardwert von

n_estimatorsänderte sich von 10 auf 100 in 0.22.- criterion{“gini”, “entropy”, “log_loss”}, Standard=”gini”

Die Funktion zur Messung der Qualität einer Teilung. Unterstützte Kriterien sind „gini“ für die Gini-Impurity und „log_loss“ sowie „entropy“ für den Shannon-Informationsgewinn, siehe Mathematische Formulierung. Hinweis: Dieser Parameter ist baumspezifisch.

- max_depthint, Standard=None

Die maximale Tiefe des Baumes. Wenn None, dann werden Knoten erweitert, bis alle Blätter rein sind oder bis alle Blätter weniger als min_samples_split Samples enthalten.

- min_samples_splitint oder float, Standard=2

Die minimale Anzahl von Samples, die zur Aufteilung eines internen Knotens erforderlich sind.

Wenn int, dann betrachte

min_samples_splitals die minimale Anzahl.Wenn float, dann ist

min_samples_splitein Bruchteil undceil(min_samples_split * n_samples)ist die minimale Anzahl von Samples für jeden Split.

Geändert in Version 0.18: Float-Werte für Brüche hinzugefügt.

- min_samples_leafint oder float, Standard=1

Die minimale Anzahl von Samples, die an einem Blattknoten erforderlich sind. Ein Splitpunkt in beliebiger Tiefe wird nur berücksichtigt, wenn er mindestens

min_samples_leafTrainingssamples in jedem der linken und rechten Zweige hinterlässt. Dies kann insbesondere bei der Regression zur Glättung des Modells beitragen.Wenn int, dann betrachte

min_samples_leafals die minimale Anzahl.Wenn float, dann ist

min_samples_leafein Bruchteil undceil(min_samples_leaf * n_samples)ist die minimale Anzahl von Samples für jeden Knoten.

Geändert in Version 0.18: Float-Werte für Brüche hinzugefügt.

- min_weight_fraction_leaffloat, Standard=0.0

Der minimale gewichtete Bruchteil der Summe aller Gewichte (aller Eingabesamplings), der in einem Blattknoten erforderlich ist. Samples haben gleiche Gewichte, wenn sample_weight nicht angegeben ist.

- max_features{„sqrt“, „log2“, None}, int oder float, Standard=”sqrt”

Die Anzahl der Features, die bei der Suche nach dem besten Split berücksichtigt werden.

Wenn int, dann werden

max_featuresFeatures bei jedem Split berücksichtigt.Wenn float, dann ist

max_featuresein Bruchteil undmax(1, int(max_features * n_features_in_))Features werden bei jedem Split berücksichtigt.Wenn "sqrt", dann

max_features=sqrt(n_features).Wenn "log2", dann

max_features=log2(n_features).Wenn None, dann

max_features=n_features.

Geändert in Version 1.1: Der Standardwert von

max_featuresänderte sich von"auto"zu"sqrt".Hinweis: Die Suche nach einem Split stoppt nicht, bis mindestens eine gültige Partition der Knoten-Samples gefunden wurde, auch wenn dies die Inspektion von mehr als

max_featuresFeatures erfordert.- max_leaf_nodesint, Standard=None

Bäume mit

max_leaf_nodesim Best-First-Verfahren wachsen lassen. Beste Knoten werden als relative Verringerung der Unreinheit definiert. Wenn None, dann unbegrenzte Anzahl von Blattknoten.- min_impurity_decreasefloat, Standard=0.0

Ein Knoten wird geteilt, wenn dieser Split eine Verringerung der Unreinheit von mindestens diesem Wert bewirkt.

Die gewichtete Gleichung für die Verringerung der Unreinheit lautet:

N_t / N * (impurity - N_t_R / N_t * right_impurity - N_t_L / N_t * left_impurity)

wobei

Ndie Gesamtzahl der Samples,N_tdie Anzahl der Samples im aktuellen Knoten,N_t_Ldie Anzahl der Samples im linken Kind undN_t_Rdie Anzahl der Samples im rechten Kind ist.N,N_t,N_t_RundN_t_Lbeziehen sich alle auf die gewichtete Summe, wennsample_weightübergeben wird.Hinzugefügt in Version 0.19.

- bootstrapbool, default=True

Ob Bootstrap-Samples beim Aufbau von Bäumen verwendet werden. Wenn False, wird der gesamte Datensatz zum Aufbau jedes Baumes verwendet.

- oob_scorebool oder callable, Standard=False

Ob Out-of-Bag-Samples zur Schätzung des Generalisierungs-Scores verwendet werden sollen. Standardmäßig wird

accuracy_scoreverwendet. Geben Sie eine aufrufbare Funktion mit der Signaturmetric(y_true, y_pred)an, um eine benutzerdefinierte Metrik zu verwenden. Nur verfügbar, wennbootstrap=True.Eine Illustration der Out-of-Bag (OOB)-Fehlerschätzung finden Sie im Beispiel OOB-Fehler für Random Forests.

- n_jobsint, default=None

Die Anzahl der parallel auszuführenden Jobs.

fit,predict,decision_pathundapplywerden alle über die Bäume parallelisiert.Nonebedeutet 1, es sei denn, es befindet sich in einemjoblib.parallel_backend-Kontext.-1bedeutet, alle Prozessoren zu verwenden. Weitere Details finden Sie im Glossar.- random_stateint, RandomState-Instanz oder None, default=None

Steuert sowohl die Zufälligkeit der Bootstraps von Stichproben, die beim Aufbau von Bäumen verwendet werden (wenn

bootstrap=True), als auch die Zufälligkeit der Merkmale, die bei der Suche nach der besten Teilung an jedem Knoten berücksichtigt werden (wennmax_features < n_features). Details finden Sie im Glossar.- verboseint, default=0

Steuert die Ausführlichkeit beim Anpassen und Vorhersagen.

- warm_startbool, Standard=False

Wenn auf

Truegesetzt, wird die Lösung des vorherigen Aufrufs von fit wiederverwendet und dem Ensemble weitere Estimators hinzugefügt, andernfalls wird nur ein komplett neues Forest erstellt. Siehe Glossar und Zusätzliche Bäume anpassen für Details.- class_weight{„balanced“, „balanced_subsample“}, dict oder Liste von dicts, Standard=None

Gewichte, die den Klassen zugeordnet sind, in der Form

{class_label: weight}. Wenn nicht angegeben, wird angenommen, dass alle Klassen das Gewicht eins haben. Bei Multi-Output-Problemen kann eine Liste von dicts in der gleichen Reihenfolge wie die Spalten von y angegeben werden.Beachten Sie, dass bei Multi-Output (einschließlich Multilabel) Gewichte für jede Klasse jeder Spalte in einem eigenen Dict definiert werden müssen. Zum Beispiel sollten bei einer Vierklassen-Multilabel-Klassifizierung Gewichte [{0: 1, 1: 1}, {0: 1, 1: 5}, {0: 1, 1: 1}, {0: 1, 1: 1}] anstelle von [{1:1}, {2:5}, {3:1}, {4:1}] angegeben werden.

Der Modus "balanced" verwendet die Werte von y, um die Gewichte umgekehrt proportional zur Klassenverteilung in den Eingabedaten automatisch anzupassen, als

n_samples / (n_classes * np.bincount(y))Der Modus „balanced_subsample“ ist derselbe wie „balanced“, außer dass die Gewichte basierend auf der Bootstrap-Stichprobe für jeden wachsenden Baum berechnet werden.

Für Multi-Output werden die Gewichte jeder Spalte von y multipliziert.

Beachten Sie, dass diese Gewichte mit sample_weight (das über die fit-Methode übergeben wird) multipliziert werden, wenn sample_weight angegeben ist.

- ccp_alphanicht-negativer float, Standard=0.0

Komplexitätsparameter, der für das prudenbasierte "Minimal Cost-Complexity Pruning" verwendet wird. Es wird der Teilbaum mit der größten Kostenkomplexität gewählt, der kleiner als

ccp_alphaist. Standardmäßig erfolgt kein Pruning. Siehe Pruning nach Kostenkomplexität für Details. Siehe Entscheidungsbäume durch Kostenkomplexitäts-Pruning nachbearbeiten für ein Beispiel eines solchen Prunings.Hinzugefügt in Version 0.22.

- max_samplesint oder float, Standard=None

Wenn bootstrap True ist, die Anzahl der Samples, die aus X gezogen werden, um jeden Basis-Estimator zu trainieren.

Wenn None (Standard), dann werden

X.shape[0]Samples gezogen.Wenn int, dann werden

max_samplesSamples gezogen.Wenn Float, dann werden

max(round(n_samples * max_samples), 1)Stichproben gezogen. Daher solltemax_samplesim Intervall(0.0, 1.0]liegen.

Hinzugefügt in Version 0.22.

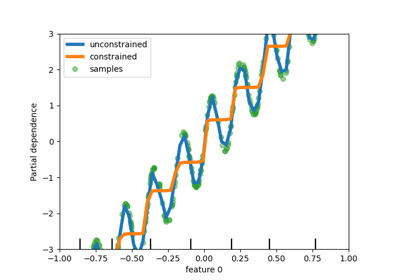

- monotonic_cstarray-like von int der Form (n_features,), Standard=None

- Gibt die zu erzwingende Monotonie-Beschränkung für jedes Merkmal an.

1: monoton steigend

0: keine Beschränkung

-1: monoton fallend

Wenn monotonic_cst None ist, werden keine Beschränkungen angewendet.

- Monotonie-Beschränkungen werden nicht unterstützt für

Mehrklassen-Klassifizierungen (d.h. wenn

n_classes > 2),Multi-Output-Klassifizierungen (d.h. wenn

n_outputs_ > 1),Klassifizierungen, die auf Daten mit fehlenden Werten trainiert wurden.

Die Beschränkungen gelten für die Wahrscheinlichkeit der positiven Klasse.

Lesen Sie mehr im Benutzerhandbuch.

Hinzugefügt in Version 1.4.

- Attribute:

- estimator_

DecisionTreeClassifier Die Kind-Estimator-Vorlage, die zum Erstellen der Sammlung von angepassten Unter-Estimators verwendet wird.

Hinzugefügt in Version 1.2:

base_estimator_wurde inestimator_umbenannt.- estimators_Liste von DecisionTreeClassifier

Die Sammlung der angepassten Unter-Estimators.

- classes_ndarray der Form (n_classes,) oder eine Liste solcher Arrays

Die Klassenbezeichnungen (einzelne Ausgabe), oder eine Liste von Arrays mit Klassenbezeichnungen (Multi-Output).

- n_classes_int oder Liste

Die Anzahl der Klassen (einzelnes Ausgabe-Problem) oder eine Liste, die die Anzahl der Klassen für jede Ausgabe enthält (Multi-Output-Problem).

- n_features_in_int

Anzahl der während des fits gesehenen Merkmale.

Hinzugefügt in Version 0.24.

- feature_names_in_ndarray mit Form (

n_features_in_,) Namen der während fit gesehenen Merkmale. Nur definiert, wenn

XMerkmalnamen hat, die alle Zeichenketten sind.Hinzugefügt in Version 1.0.

- n_outputs_int

Die Anzahl der Ausgaben, wenn

fitausgeführt wird.feature_importances_ndarray der Form (n_features,)Die Unreinheits-basierten Wichtigkeiten der Features.

- oob_score_float

Score des Trainingsdatensatzes, der mit einer Out-of-Bag-Schätzung erzielt wurde. Dieses Attribut existiert nur, wenn

oob_scoreTrue ist.- oob_decision_function_ndarray der Form (n_samples, n_classes) oder (n_samples, n_classes, n_outputs)

Entscheidungsfunktion, berechnet mit Out-of-Bag-Schätzung auf dem Trainingsset. Wenn n_estimators klein ist, kann es vorkommen, dass ein Datenpunkt nie bei der Bootstrap-Auswahl ausgelassen wurde. In diesem Fall kann

oob_decision_function_NaN enthalten. Dieses Attribut existiert nur, wennoob_scoreTrue ist.estimators_samples_Liste von ArraysDie Teilmenge der gezogenen Samples für jeden Basis-Estimator.

- estimator_

Siehe auch

sklearn.tree.DecisionTreeClassifierEin Entscheidungsbaum-Klassifikator.

sklearn.ensemble.ExtraTreesClassifierEnsemble von extrem zufälligen Baumklassifikatoren.

sklearn.ensemble.HistGradientBoostingClassifierEin histogrammbasierter Gradient Boosting Klassifikationsbaum, sehr schnell für große Datensätze (n_samples >= 10_000).

Anmerkungen

Die Standardwerte für die Parameter, die die Größe der Bäume steuern (z. B.

max_depth,min_samples_leafusw.), führen zu vollständig gewachsenen und un-geprunten Bäumen, die auf einigen Datensätzen potenziell sehr groß sein können. Um den Speicherverbrauch zu reduzieren, sollte die Komplexität und Größe der Bäume durch Setzen dieser Parameterwerte gesteuert werden.Die Merkmale werden bei jeder Teilung immer zufällig permutiert. Daher kann die gefundene beste Teilung variieren, selbst bei denselben Trainingsdaten,

max_features=n_featuresundbootstrap=False, wenn die Verbesserung des Kriteriums für mehrere während der Suche nach der besten Teilung aufgeführte Teilungen identisch ist. Um ein deterministisches Verhalten während des Anpassens zu erzielen, mussrandom_statefestgelegt werden.Referenzen

Beispiele

>>> from sklearn.ensemble import RandomForestClassifier >>> from sklearn.datasets import make_classification >>> X, y = make_classification(n_samples=1000, n_features=4, ... n_informative=2, n_redundant=0, ... random_state=0, shuffle=False) >>> clf = RandomForestClassifier(max_depth=2, random_state=0) >>> clf.fit(X, y) RandomForestClassifier(...) >>> print(clf.predict([[0, 0, 0, 0]])) [1]

- apply(X)[Quelle]#

Wendet die Bäume im Forest auf X an, gibt Blattindizes zurück.

- Parameter:

- X{array-like, sparse matrix} der Form (n_samples, n_features)

Die Eingabesamplings. Intern wird der dtype zu

dtype=np.float32konvertiert. Wenn eine dünn besetzte Matrix bereitgestellt wird, wird sie in eine dünn besetztecsr_matrixkonvertiert.

- Gibt zurück:

- X_leavesndarray der Form (n_samples, n_estimators)

Gibt für jeden Datenpunkt x in X und für jeden Baum im Forest den Index des Blattes zurück, in das x gelangt.

- decision_path(X)[Quelle]#

Gibt den Entscheidungsbaum im Forest zurück.

Hinzugefügt in Version 0.18.

- Parameter:

- X{array-like, sparse matrix} der Form (n_samples, n_features)

Die Eingabesamplings. Intern wird der dtype zu

dtype=np.float32konvertiert. Wenn eine dünn besetzte Matrix bereitgestellt wird, wird sie in eine dünn besetztecsr_matrixkonvertiert.

- Gibt zurück:

- indicatordünn besetzte Matrix der Form (n_samples, n_nodes)

Gibt eine Knotenindikatormatrix zurück, bei der Nicht-Null-Elemente darauf hinweisen, dass die Samples die Knoten durchlaufen. Die Matrix ist im CSR-Format.

- n_nodes_ptrndarray der Form (n_estimators + 1,)

Die Spalten von indicator[n_nodes_ptr[i]:n_nodes_ptr[i+1]] geben den Indikatorwert für den i-ten Estimator an.

- fit(X, y, sample_weight=None)[Quelle]#

Baut einen Forest von Bäumen aus dem Trainingsset (X, y) auf.

- Parameter:

- X{array-like, sparse matrix} der Form (n_samples, n_features)

Die Trainings-Eingabesamplings. Intern wird der dtype zu

dtype=np.float32konvertiert. Wenn eine dünn besetzte Matrix bereitgestellt wird, wird sie in eine dünn besetztecsc_matrixkonvertiert.- yarray-like der Form (n_samples,) oder (n_samples, n_outputs)

Die Zielwerte (Klassenbezeichnungen bei Klassifizierung, reelle Zahlen bei Regression).

- sample_weightarray-like der Form (n_samples,), Standardwert=None

Sample-Gewichte. Wenn None, dann werden die Samples gleich gewichtet. Splits, die Kindknoten mit Nettogewicht Null oder negativ erzeugen würden, werden bei der Suche nach einem Split in jedem Knoten ignoriert. Im Falle einer Klassifizierung werden Splits auch ignoriert, wenn sie dazu führen würden, dass eine einzelne Klasse in einem Kindknoten ein negatives Gewicht trägt.

- Gibt zurück:

- selfobject

Angepasster Schätzer.

- get_metadata_routing()[Quelle]#

Holt das Metadaten-Routing dieses Objekts.

Bitte prüfen Sie im Benutzerhandbuch, wie der Routing-Mechanismus funktioniert.

- Gibt zurück:

- routingMetadataRequest

Ein

MetadataRequest, der Routing-Informationen kapselt.

- get_params(deep=True)[Quelle]#

Holt Parameter für diesen Schätzer.

- Parameter:

- deepbool, default=True

Wenn True, werden die Parameter für diesen Schätzer und die enthaltenen Unterobjekte, die Schätzer sind, zurückgegeben.

- Gibt zurück:

- paramsdict

Parameternamen, zugeordnet ihren Werten.

- predict(X)[Quelle]#

Sagt die Klasse für X voraus.

Die vorhergesagte Klasse einer Eingabestichprobe ist eine Abstimmung der Bäume im Forest, gewichtet nach ihren Wahrscheinlichkeitsschätzungen. Das heißt, die vorhergesagte Klasse ist diejenige mit der höchsten mittleren Wahrscheinlichkeitsschätzung über die Bäume hinweg.

- Parameter:

- X{array-like, sparse matrix} der Form (n_samples, n_features)

Die Eingabesamplings. Intern wird der dtype zu

dtype=np.float32konvertiert. Wenn eine dünn besetzte Matrix bereitgestellt wird, wird sie in eine dünn besetztecsr_matrixkonvertiert.

- Gibt zurück:

- yndarray der Form (n_samples,) oder (n_samples, n_outputs)

Die vorhergesagten Klassen.

- predict_log_proba(X)[Quelle]#

Sagt die logarithmierte Klassenwahrscheinlichkeit für X voraus.

Die vorhergesagten logarithmischen Klassenzugrundeliegenden Wahrscheinlichkeiten einer Eingabestichprobe werden als Logarithmus der mittleren vorhergesagten Klassenzugrundeliegenden Wahrscheinlichkeiten der Bäume im Forest berechnet.

- Parameter:

- X{array-like, sparse matrix} der Form (n_samples, n_features)

Die Eingabesamplings. Intern wird der dtype zu

dtype=np.float32konvertiert. Wenn eine dünn besetzte Matrix bereitgestellt wird, wird sie in eine dünn besetztecsr_matrixkonvertiert.

- Gibt zurück:

- pndarray der Form (n_samples, n_classes) oder eine Liste solcher Arrays

Die Klassenwahrscheinlichkeiten der Eingabesamplings. Die Reihenfolge der Klassen entspricht der im Attribut classes_.

- predict_proba(X)[Quelle]#

Sagt die Klassenwahrscheinlichkeiten für X voraus.

Die vorhergesagten Klassenzugrundeliegenden Wahrscheinlichkeiten einer Eingabestichprobe werden als Durchschnitt der vorhergesagten Klassenzugrundeliegenden Wahrscheinlichkeiten der Bäume im Forest berechnet. Die Klassenzugrundeliegende Wahrscheinlichkeit eines einzelnen Baumes ist der Bruchteil der Stichproben derselben Klasse in einem Blatt.

- Parameter:

- X{array-like, sparse matrix} der Form (n_samples, n_features)

Die Eingabesamplings. Intern wird der dtype zu

dtype=np.float32konvertiert. Wenn eine dünn besetzte Matrix bereitgestellt wird, wird sie in eine dünn besetztecsr_matrixkonvertiert.

- Gibt zurück:

- pndarray der Form (n_samples, n_classes) oder eine Liste solcher Arrays

Die Klassenwahrscheinlichkeiten der Eingabesamplings. Die Reihenfolge der Klassen entspricht der im Attribut classes_.

- score(X, y, sample_weight=None)[Quelle]#

Gibt die Genauigkeit für die bereitgestellten Daten und Bezeichnungen zurück.

Bei der Multi-Label-Klassifizierung ist dies die Subset-Genauigkeit, eine strenge Metrik, da für jede Stichprobe verlangt wird, dass jede Label-Menge korrekt vorhergesagt wird.

- Parameter:

- Xarray-like der Form (n_samples, n_features)

Teststichproben.

- yarray-like der Form (n_samples,) oder (n_samples, n_outputs)

Wahre Bezeichnungen für

X.- sample_weightarray-like der Form (n_samples,), Standardwert=None

Stichprobengewichte.

- Gibt zurück:

- scorefloat

Mittlere Genauigkeit von

self.predict(X)in Bezug aufy.

- set_fit_request(*, sample_weight: bool | None | str = '$UNCHANGED$') RandomForestClassifier[Quelle]#

Konfiguriert, ob Metadaten für die

fit-Methode angefordert werden sollen.Beachten Sie, dass diese Methode nur relevant ist, wenn dieser Schätzer als Unter-Schätzer innerhalb eines Meta-Schätzers verwendet wird und Metadaten-Routing mit

enable_metadata_routing=Trueaktiviert ist (siehesklearn.set_config). Bitte lesen Sie das Benutzerhandbuch, um zu erfahren, wie der Routing-Mechanismus funktioniert.Die Optionen für jeden Parameter sind

True: Metadaten werden angefordert und, falls vorhanden, anfitübergeben. Die Anforderung wird ignoriert, wenn keine Metadaten vorhanden sind.False: Metadaten werden nicht angefordert und der Meta-Schätzer übergibt sie nicht anfit.None: Metadaten werden nicht angefordert und der Meta-Schätzer löst einen Fehler aus, wenn der Benutzer sie bereitstellt.str: Metadaten sollten mit diesem Alias an den Meta-Schätzer übergeben werden und nicht mit dem ursprünglichen Namen.

Der Standardwert (

sklearn.utils.metadata_routing.UNCHANGED) behält die bestehende Anforderung bei. Dies ermöglicht es Ihnen, die Anforderung für einige Parameter zu ändern und für andere nicht.Hinzugefügt in Version 1.3.

- Parameter:

- sample_weightstr, True, False, oder None, Standardwert=sklearn.utils.metadata_routing.UNCHANGED

Metadaten-Routing für den Parameter

sample_weightinfit.

- Gibt zurück:

- selfobject

Das aktualisierte Objekt.

- set_params(**params)[Quelle]#

Setzt die Parameter dieses Schätzers.

Die Methode funktioniert sowohl bei einfachen Schätzern als auch bei verschachtelten Objekten (wie

Pipeline). Letztere haben Parameter der Form<component>__<parameter>, so dass es möglich ist, jede Komponente eines verschachtelten Objekts zu aktualisieren.- Parameter:

- **paramsdict

Schätzer-Parameter.

- Gibt zurück:

- selfestimator instance

Schätzer-Instanz.

- set_score_request(*, sample_weight: bool | None | str = '$UNCHANGED$') RandomForestClassifier[Quelle]#

Konfiguriert, ob Metadaten für die

score-Methode angefordert werden sollen.Beachten Sie, dass diese Methode nur relevant ist, wenn dieser Schätzer als Unter-Schätzer innerhalb eines Meta-Schätzers verwendet wird und Metadaten-Routing mit

enable_metadata_routing=Trueaktiviert ist (siehesklearn.set_config). Bitte lesen Sie das Benutzerhandbuch, um zu erfahren, wie der Routing-Mechanismus funktioniert.Die Optionen für jeden Parameter sind

True: Metadaten werden angefordert und, falls vorhanden, anscoreübergeben. Die Anforderung wird ignoriert, wenn keine Metadaten vorhanden sind.False: Metadaten werden nicht angefordert und der Meta-Schätzer übergibt sie nicht anscore.None: Metadaten werden nicht angefordert und der Meta-Schätzer löst einen Fehler aus, wenn der Benutzer sie bereitstellt.str: Metadaten sollten mit diesem Alias an den Meta-Schätzer übergeben werden und nicht mit dem ursprünglichen Namen.

Der Standardwert (

sklearn.utils.metadata_routing.UNCHANGED) behält die bestehende Anforderung bei. Dies ermöglicht es Ihnen, die Anforderung für einige Parameter zu ändern und für andere nicht.Hinzugefügt in Version 1.3.

- Parameter:

- sample_weightstr, True, False, oder None, Standardwert=sklearn.utils.metadata_routing.UNCHANGED

Metadaten-Routing für den Parameter

sample_weightinscore.

- Gibt zurück:

- selfobject

Das aktualisierte Objekt.

Galeriebeispiele#

Wahrscheinlichkeitskalibrierung für 3-Klassen-Klassifikation

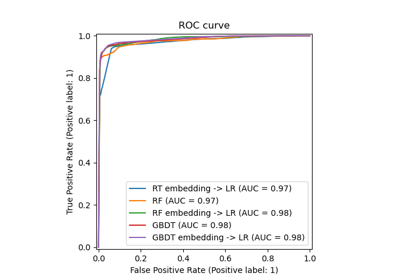

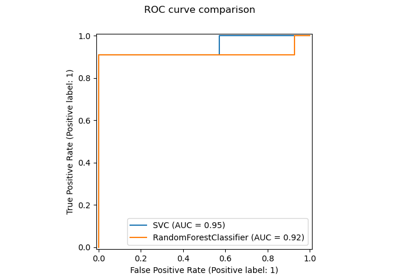

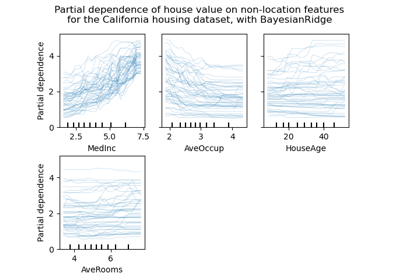

Vergleich von Random Forests und Histogram Gradient Boosting Modellen

Entscheidungsflächen von Ensembles von Bäumen auf dem Iris-Datensatz plotten

Permutations-Wichtigkeit vs. Random Forest Merkmals-Wichtigkeit (MDI)

Permutations-Wichtigkeit bei multikollinearen oder korrelierten Merkmalen

Klassifikation von Textdokumenten mit spärlichen Merkmalen