enet_path#

- sklearn.linear_model.enet_path(X, y, *, l1_ratio=0.5, eps=0.001, n_alphas=100, alphas=None, precompute='auto', Xy=None, copy_X=True, coef_init=None, verbose=False, return_n_iter=False, positive=False, check_input=True, **params)[Quelle]#

Berechnet den Elastic Net-Pfad mit Koordinatenabstieg.

Die Elastic-Net-Optimierungsfunktion variiert für Mono- und Multi-Ausgaben.

Für Mono-Ausgaben-Aufgaben ist es

1 / (2 * n_samples) * ||y - Xw||^2_2 + alpha * l1_ratio * ||w||_1 + 0.5 * alpha * (1 - l1_ratio) * ||w||^2_2

Für Multi-Ausgaben-Aufgaben ist es

(1 / (2 * n_samples)) * ||Y - XW||_Fro^2 + alpha * l1_ratio * ||W||_21 + 0.5 * alpha * (1 - l1_ratio) * ||W||_Fro^2

Wo

||W||_21 = \sum_i \sqrt{\sum_j w_{ij}^2}

d.h. die Summe der Norm jeder Zeile.

Lesen Sie mehr im Benutzerhandbuch.

- Parameter:

- X{array-like, sparse matrix} der Form (n_samples, n_features)

Trainingsdaten. Direkt als Fortran-kontinuierliche Daten übergeben, um unnötige Speicherduplizierung zu vermeiden. Wenn

yeine Mono-Ausgabe ist, kannXspärlich sein.- y{array-ähnlich, spärsitätsmatrix} der Form (n_samples,) oder (n_samples, n_targets)

Zielwerte.

- l1_ratiofloat, Standardwert=0.5

Zahl zwischen 0 und 1, die an Elastic Net übergeben wird (Skalierung zwischen l1- und l2-Strafen).

l1_ratio=1entspricht dem Lasso.- epsfloat, Standardwert=1e-3

Länge des Pfades.

eps=1e-3bedeutet, dassalpha_min / alpha_max = 1e-3.- n_alphasint, Standardwert=100

Anzahl der Alphas entlang des Regularisierungspfades.

- alphasarray-ähnlich, Standardwert=None

Liste von Alphas, für die die Modelle berechnet werden. Wenn None, werden Alphas automatisch gesetzt.

- precompute‘auto‘, bool oder array-ähnlich der Form (n_features, n_features), Standardwert=’auto’

Ob eine vorberechnete Gram-Matrix verwendet werden soll, um Berechnungen zu beschleunigen. Wenn auf

'auto'gesetzt, entscheiden wir. Die Gram-Matrix kann auch als Argument übergeben werden.- Xyarray-ähnlich der Form (n_features,) oder (n_features, n_targets), Standardwert=None

Xy = np.dot(X.T, y), was vorab berechnet werden kann. Dies ist nur nützlich, wenn die Gram-Matrix vorab berechnet wurde.

- copy_Xbool, Standardwert=True

Wenn

True, wird X kopiert; andernfalls kann es überschrieben werden.- coef_initarray-ähnlich der Form (n_features,), Standardwert=None

Die Anfangswerte der Koeffizienten.

- verbosebool oder int, default=False

Ausmaß der Ausführlichkeit.

- return_n_iterbool, Standard=False

Ob die Anzahl der Iterationen zurückgegeben werden soll oder nicht.

- positivebool, Standardwert=False

Wenn True gesetzt, werden die Koeffizienten auf positiv erzwungen. (Nur erlaubt, wenn

y.ndim == 1).- check_inputbool, Standardwert=True

Wenn False gesetzt, werden die Eingabevalidierungsprüfungen übersprungen (einschließlich der Gram-Matrix, wenn sie bereitgestellt wird). Es wird davon ausgegangen, dass diese vom Aufrufer behandelt werden.

- **paramskwargs

Schlüsselwortargumente, die an den Koordinatenabstiegslöser übergeben werden.

- Gibt zurück:

- alphasndarray der Form (n_alphas,)

Die Alphas entlang des Pfades, auf dem Modelle berechnet werden.

- coefsndarray der Form (n_features, n_alphas) oder (n_targets, n_features, n_alphas)

Koeffizienten entlang des Pfades.

- dual_gapsndarray der Form (n_alphas,)

Die dualen Abstände am Ende der Optimierung für jedes Alpha.

- n_iterslist von int

Die Anzahl der Iterationen, die der Koordinatenabstieg-Optimierer benötigt, um die angegebene Toleranz für jedes Alpha zu erreichen. (Wird zurückgegeben, wenn

return_n_iterauf True gesetzt ist).

Siehe auch

MultiTaskElasticNetMulti-Task ElasticNet Modell, trainiert mit L1/L2 Mixed-Norm als Regularisator.

MultiTaskElasticNetCVMulti-Task L1/L2 ElasticNet mit integrierter Kreuzvalidierung.

ElasticNetLineares Modell mit kombinierter L1- und L2-Prior als Regularisator.

ElasticNetCVElastic Net Modell mit iterativem Anpassen entlang eines Regularisierungspfades.

Anmerkungen

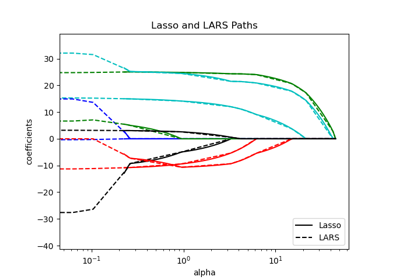

Ein Beispiel finden Sie unter Beispiele/linear_model/plot_lasso_lasso_lars_elasticnet_path.py.

Der zugrunde liegende Koordinatenabstiegslöser verwendet "gap-safe screening rules", um die Anpassungszeit zu beschleunigen, siehe Benutzerhandbuch zum Koordinatenabstieg.

Beispiele

>>> from sklearn.linear_model import enet_path >>> from sklearn.datasets import make_regression >>> X, y, true_coef = make_regression( ... n_samples=100, n_features=5, n_informative=2, coef=True, random_state=0 ... ) >>> true_coef array([ 0. , 0. , 0. , 97.9, 45.7]) >>> alphas, estimated_coef, _ = enet_path(X, y, n_alphas=3) >>> alphas.shape (3,) >>> estimated_coef array([[ 0., 0.787, 0.568], [ 0., 1.120, 0.620], [-0., -2.129, -1.128], [ 0., 23.046, 88.939], [ 0., 10.637, 41.566]])