l1_min_c#

- sklearn.svm.l1_min_c(X, y, *, loss='squared_hinge', fit_intercept=True, intercept_scaling=1.0)[Quelle]#

Gibt die unterste Grenze für

Czurück.Die untere Grenze für

Cwird so berechnet, dass fürCin(l1_min_C, infinity)garantiert ist, dass das Modell nicht leer ist. Dies gilt für l1-penalisierte Klassifikatoren wiesklearn.svm.LinearSVCmit penalty=’l1’ undsklearn.linear_model.LogisticRegressionmitl1_ratio=1.Dieser Wert ist gültig, wenn der Parameter

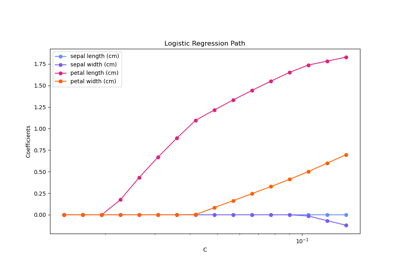

class_weightinfit()nicht gesetzt ist.Ein Beispiel für die Verwendung dieser Funktion finden Sie unter Regularisierungspfad von L1-logistischer Regression.

- Parameter:

- X{array-like, sparse matrix} der Form (n_samples, n_features)

Trainingsvektor, wobei

n_samplesdie Anzahl der Stichproben undn_featuresdie Anzahl der Merkmale ist.- yarray-like von Form (n_samples,)

Zielvektor relativ zu X.

- loss{‘squared_hinge’, ‘log’}, Standardwert=’squared_hinge’

Gibt die Verlustfunktion an. Mit ‘squared_hinge’ ist es der quadratische Hinge-Verlust (auch L2-Verlust genannt). Mit ‘log’ ist es der Verlust von logistischen Regressionsmodellen.

- fit_interceptbool, Standardwert=True

Gibt an, ob der Achsenabschnitt vom Modell angepasst werden soll. Es muss dem Parameter der fit()-Methode entsprechen.

- intercept_scalingfloat, Standardwert=1.0

Wenn fit_intercept True ist, wird der Instanzvektor x zu [x, intercept_scaling], d.h. ein „synthetisches“ Merkmal mit konstantem Wert gleich intercept_scaling wird an den Instanzvektor angehängt. Es muss dem Parameter der fit()-Methode entsprechen.

- Gibt zurück:

- l1_min_cfloat

Minimaler Wert für C.

Beispiele

>>> from sklearn.svm import l1_min_c >>> from sklearn.datasets import make_classification >>> X, y = make_classification(n_samples=100, n_features=20, random_state=42) >>> print(f"{l1_min_c(X, y, loss='squared_hinge', fit_intercept=True):.4f}") 0.0044

Galeriebeispiele#

Regularisierungspfad der L1-Logistischen Regression