Hinweis

Zum Ende springen, um den vollständigen Beispielcode herunterzuladen oder dieses Beispiel über JupyterLite oder Binder in Ihrem Browser auszuführen.

Zufällig generiertes Multilabel-Datenset plotten#

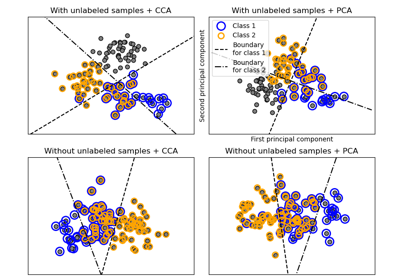

Dies illustriert den Datensatzgenerator make_multilabel_classification. Jede Stichprobe besteht aus Zählungen von zwei Merkmalen (bis zu 50 insgesamt), die in jeder von zwei Klassen unterschiedlich verteilt sind.

Punkte werden wie folgt beschriftet, wobei Y bedeutet, dass die Klasse vorhanden ist

1 |

2 |

3 |

Farbe |

|---|---|---|---|

Y |

N |

N |

Rot |

N |

Y |

N |

Blau |

N |

N |

Y |

Gelb |

Y |

Y |

N |

Violett |

Y |

N |

Y |

Orange |

Y |

Y |

N |

Grün |

Y |

Y |

Y |

Braun |

Ein Stern markiert die erwartete Stichprobe für jede Klasse; seine Größe spiegelt die Wahrscheinlichkeit der Auswahl dieser Klassenbezeichnung wider.

Die linken und rechten Beispiele heben den Parameter n_labels hervor: mehr der Stichproben im rechten Plot haben 2 oder 3 Labels.

Beachten Sie, dass dieses zweidimensionale Beispiel sehr degeneriert ist: Im Allgemeinen wäre die Anzahl der Merkmale viel größer als die "Dokumentenlänge", während wir hier viel größere Dokumente als Vokabular haben. Ebenso ist es bei n_classes > n_features viel unwahrscheinlicher, dass ein Merkmal eine bestimmte Klasse unterscheidet.

The data was generated from (random_state=939):

Class P(C) P(w0|C) P(w1|C)

red 0.52 0.46 0.54

blue 0.28 0.59 0.41

yellow 0.19 0.50 0.50

# Authors: The scikit-learn developers

# SPDX-License-Identifier: BSD-3-Clause

import matplotlib.pyplot as plt

import numpy as np

from sklearn.datasets import make_multilabel_classification as make_ml_clf

COLORS = np.array(

[

"!",

"#FF3333", # red

"#0198E1", # blue

"#BF5FFF", # purple

"#FCD116", # yellow

"#FF7216", # orange

"#4DBD33", # green

"#87421F", # brown

]

)

# Use same random seed for multiple calls to make_multilabel_classification to

# ensure same distributions

RANDOM_SEED = np.random.randint(2**10)

def plot_2d(ax, n_labels=1, n_classes=3, length=50):

X, Y, p_c, p_w_c = make_ml_clf(

n_samples=150,

n_features=2,

n_classes=n_classes,

n_labels=n_labels,

length=length,

allow_unlabeled=False,

return_distributions=True,

random_state=RANDOM_SEED,

)

ax.scatter(

X[:, 0], X[:, 1], color=COLORS.take((Y * [1, 2, 4]).sum(axis=1)), marker="."

)

ax.scatter(

p_w_c[0] * length,

p_w_c[1] * length,

marker="*",

linewidth=0.5,

edgecolor="black",

s=20 + 1500 * p_c**2,

color=COLORS.take([1, 2, 4]),

)

ax.set_xlabel("Feature 0 count")

return p_c, p_w_c

_, (ax1, ax2) = plt.subplots(1, 2, sharex="row", sharey="row", figsize=(8, 4))

plt.subplots_adjust(bottom=0.15)

p_c, p_w_c = plot_2d(ax1, n_labels=1)

ax1.set_title("n_labels=1, length=50")

ax1.set_ylabel("Feature 1 count")

plot_2d(ax2, n_labels=3)

ax2.set_title("n_labels=3, length=50")

ax2.set_xlim(left=0, auto=True)

ax2.set_ylim(bottom=0, auto=True)

plt.show()

print("The data was generated from (random_state=%d):" % RANDOM_SEED)

print("Class", "P(C)", "P(w0|C)", "P(w1|C)", sep="\t")

for k, p, p_w in zip(["red", "blue", "yellow"], p_c, p_w_c.T):

print("%s\t%0.2f\t%0.2f\t%0.2f" % (k, p, p_w[0], p_w[1]))

Gesamtlaufzeit des Skripts: (0 Minuten 0,110 Sekunden)

Verwandte Beispiele

Verwendung von KBinsDiscretizer zur Diskretisierung kontinuierlicher Merkmale

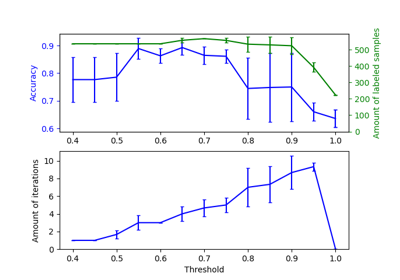

Auswirkung der Änderung des Schwellenwerts für Self-Training

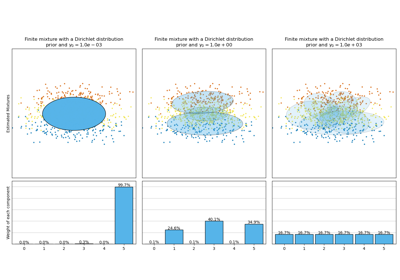

Analyse des Konzentrations-Prior-Typs der Variation im Bayes'schen Gaußschen Gemisch