Hinweis

Zum Ende springen, um den vollständigen Beispielcode herunterzuladen oder dieses Beispiel über JupyterLite oder Binder in Ihrem Browser auszuführen.

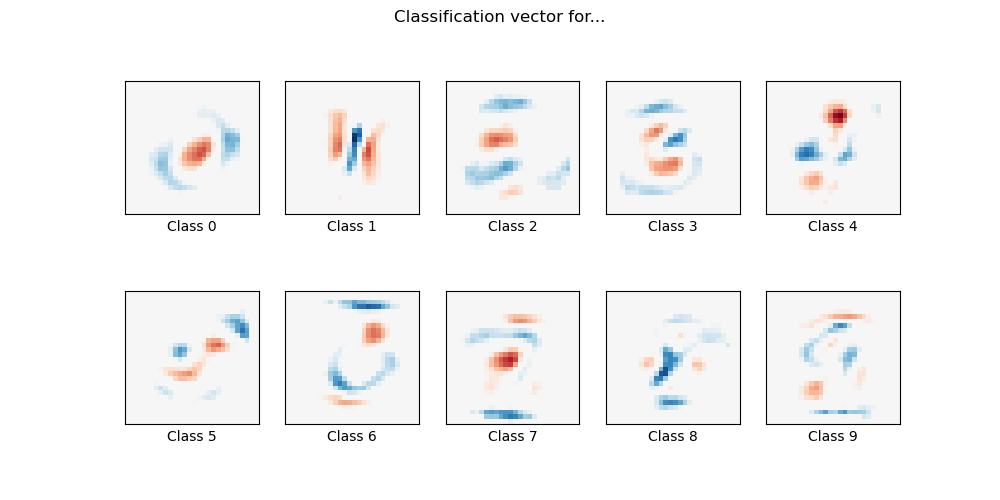

MNIST-Klassifizierung mit multinomialer Logistik + L1#

Hier passen wir eine multinomiale logistische Regression mit L1-Strafe für eine Teilmenge der MNIST-Ziffernklassifizierungsaufgabe an. Wir verwenden den SAGA-Algorithmus zu diesem Zweck: Dies ist ein Solver, der schnell ist, wenn die Anzahl der Stichproben deutlich größer ist als die Anzahl der Merkmale, und der in der Lage ist, nicht-glatte Zielfunktionen fein zu optimieren, was bei der l1-Strafe der Fall ist. Die Testgenauigkeit erreicht > 0,8, während die Gewichtungsvektoren *spärlich* und daher leichter *interpretierbar* bleiben.

Beachten Sie, dass die Genauigkeit dieses l1-bestraften linearen Modells deutlich unter der liegt, die mit einem l2-bestraften linearen Modell oder einem nicht-linearen Multi-Layer-Perceptron-Modell auf diesem Datensatz erreicht werden kann.

Sparsity with L1 penalty: 80.33%

Test score with L1 penalty: 0.8212

Example run in 10.744 s

# Authors: The scikit-learn developers

# SPDX-License-Identifier: BSD-3-Clause

import time

import matplotlib.pyplot as plt

import numpy as np

from sklearn.datasets import fetch_openml

from sklearn.linear_model import LogisticRegression

from sklearn.model_selection import train_test_split

from sklearn.preprocessing import StandardScaler

from sklearn.utils import check_random_state

# Turn down for faster convergence

t0 = time.time()

train_samples = 5000

# Load data from https://www.openml.org/d/554

X, y = fetch_openml("mnist_784", version=1, return_X_y=True, as_frame=False)

random_state = check_random_state(0)

permutation = random_state.permutation(X.shape[0])

X = X[permutation]

y = y[permutation]

X = X.reshape((X.shape[0], -1))

X_train, X_test, y_train, y_test = train_test_split(

X, y, train_size=train_samples, test_size=10000

)

scaler = StandardScaler()

X_train = scaler.fit_transform(X_train)

X_test = scaler.transform(X_test)

# Turn up tolerance for faster convergence

clf = LogisticRegression(C=50.0 / train_samples, l1_ratio=1, solver="saga", tol=0.1)

clf.fit(X_train, y_train)

sparsity = np.mean(clf.coef_ == 0) * 100

score = clf.score(X_test, y_test)

# print('Best C % .4f' % clf.C_)

print("Sparsity with L1 penalty: %.2f%%" % sparsity)

print("Test score with L1 penalty: %.4f" % score)

coef = clf.coef_.copy()

plt.figure(figsize=(10, 5))

scale = np.abs(coef).max()

for i in range(10):

l1_plot = plt.subplot(2, 5, i + 1)

l1_plot.imshow(

coef[i].reshape(28, 28),

interpolation="nearest",

cmap=plt.cm.RdBu,

vmin=-scale,

vmax=scale,

)

l1_plot.set_xticks(())

l1_plot.set_yticks(())

l1_plot.set_xlabel(f"Class {i}")

plt.suptitle("Classification vector for...")

run_time = time.time() - t0

print("Example run in %.3f s" % run_time)

plt.show()

Gesamtlaufzeit des Skripts: (0 Minuten 10,791 Sekunden)

Verwandte Beispiele

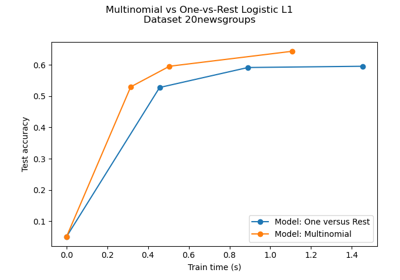

Multiklassen-Sparse-Logistische-Regression auf 20newgroups

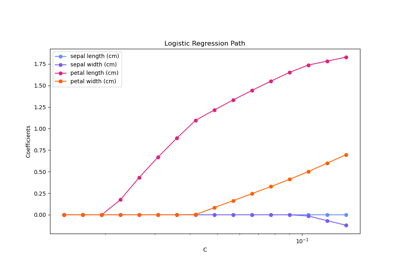

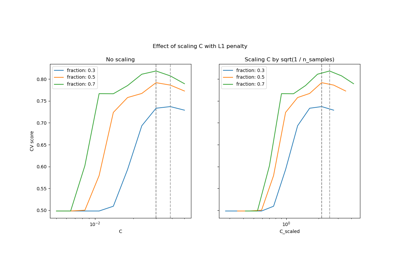

Regularisierungspfad der L1-Logistischen Regression

Skalierung des Regularisierungsparameters für SVCs